访谈|#NLP太难了# 未来媒体访谈对话黄萱菁教授|“NLP+媒体”:科技向善,做有挑战的事( 十 )

文章插图

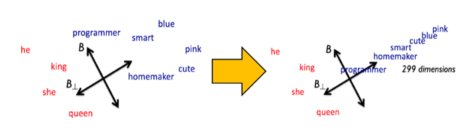

Hard debias,图源:towardsdatascience

如果我们这样做了之后,我们马上就会发现我们下游任务的性能下降了。从学术角度来说,准确率不应该是我们所关心的唯一的指标,我们也应该有这个价值观,我们怎么样能够去引导更加公平、更加平等的社会。

未来媒体访谈:其实像道德伦理已经变成了ACL的一大类别了。

黄萱菁:对,20个之一。

未来媒体访谈:对您来说,您只是从一个研究者的角度上去看的话,您觉得符合道德规范或者是道德反思做得比较好的研究应该有什么标准?您自己是怎么做这一块的反思的?

黄萱菁:其实说到伦理,它不仅仅是ACL系列的一个大类之一。我今年正好是 EMNLP的程序主席,我可以跟你讲讲我们论文的这样的一个评审过程。我们除了常规的根据论文的学术质量做评审,在投稿的时候,作者是可以写一个声明的,声明他这块工作中间的有可能有哪些伦理问题。举个例子,比如有个人在做怎么消除互联网上的污言秽语。这样的工作需要有这个人去标注垃圾用语,很可能就会把这个标注人员搞得抑郁了。

所以就是说做研究的话,我们不仅仅是不能把人当工具,也要考虑到这块工作会对从业者产生什么样的一些心理影响,这是一方面。另外一方面,就像刚才说的,如果我采集数据,数据中有很多隐私,隐私数据要清洗。比如疫情防控中间的疫情流调报告,如果漏了很多隐私,会成为吃瓜群众吃瓜的乐趣,但其实这些都不是很好的行为。

所以我们会要求作者去做一个自我声明,(说明)你的研究工作可能会带来什么样的不良伦理后果。这个声明实际上不是我们自然语言处理首先发明的,是我们引入的。有了作者自己对伦理方面的声明之后,我们会在评审过程中要求审稿人不仅要看论文的学术质量,也要看论文中间是不是会存在一些伦理风险。

考虑的比较多的有我刚才说的隐私问题,然后还有对人的(影响)的问题,还有工作的价值观是不是特别好。我们甚至可能会鼓励一些工作,你可能看它的新颖性不是特别的好,但是它是值得鼓励的,比如小语种的信息处理,像我们国内的一些少数民族语言,(这些研究)因为数据比较少,可能性能不太好,但是我们也要鼓励它,因为有重要的社会效益。在国际上的话,比如说做非洲语言的研究都是值得关注的。

文章插图

ACL Ethics FAQ 图源: 2021.aclweb.org

审稿人员会去看文章,判断它潜在的一些伦理风险,之后我们还成立了独立的伦理委员会,会去对这些文章(进行判断),如果它存在的伦理问题足够严重,那必须拒稿或者重新打回给作者,所以整个学术圈其实已经有了很多机制。我们开始关心伦理其实是比传媒、生物都要晚一点点,关注之后就觉得这里头是有很大的问题,因为我们总归是要说科技向善,要关注它的社会效益,怎么样为全人类的福祉而服务。

文章插图

ACM Code of Ethics 图源:acm.org

“现在是你们最好的时机”

未来媒体访谈:咱们最后一个问题围绕人工智能这个领域的性别平等,像刚才老师说了,如果在语义表示这一方面,我们可以用算法去纠偏,去把性别偏向逐渐的把它改过来,如果是从社会学的角度去切入这个问题的话,我们可能希望人工智能以及计算机这个领域的研究者也好、从业者也好,性别比例能够不这么悬殊。所以想问一问您,对未来有志于从事人工智能这方面领域的女性,有没有什么心得可以分享?

推荐阅读

- 中关村|焦点访谈丨“双减”一学期,效果如何

- 中关村|焦点访谈丨“双减”一学期 效果如何

- 时间|焦点访谈丨“双减”一学期 效果如何

- 中关村|焦点访谈:“双减”一学期 效果如何

- 时间|焦点访谈:“双减”一学期 效果如何

- 阅读理解|期末考试阅读题太难,学生喊话作家求“标准答案”,折射了啥?

- 排球|焦点访谈:体教融合 新思路新探索

- 青少年|焦点访谈:体教融合 新思路新探索

- 微博|学生喊话期末阅读题太难,著名作家回应

- 教师|双减之后,高三普通班复习课太难上,教师:过度关注成绩,很肤浅