访谈|#NLP太难了# 未来媒体访谈对话黄萱菁教授|“NLP+媒体”:科技向善,做有挑战的事( 六 )

那么另外既然我们是受上海市资助的这样一个项目,所以就会特别关注上海,分析上海市民在疫情中的舆情方面有什么样的变化、什么样的特点,这是当时的一些背景。

未来媒体访谈:当时其实主要还是用微博上面的数据?

黄萱菁:对,是微博上面的数据,我们做这个工作实际上时间也很短,因为大家都知道去年过年的时候,按说那个时候我们都已经放假了,但是因为一有这个需求,很多研究生也就很积极地参与了这项工作。我们大概爬了一个多月的数据,比如找了几个关键词,什么“肺炎”、“冠状病毒”、“新冠肺炎”,那个时候好像还没有“新冠肺炎”的提法,提的更多的是“肺炎”,然后我们就在微博上抓了很多的数据,大概有3000多万条,我们就发现微博的舆情是跟着疫情的。

比如当时有几个事件,像首先大家先知道新冠肺炎进入我们中的视野了,然后武汉又实行进出管控了,那么还有李文亮医生事件,微博数有好几个舆情峰值,然后我们就给他做各种各样的计算机处理,比如做词频统计、话题的频率统计,然后就分析出来两大主题——疫情信息和防疫工作。

未来媒体访谈:当时这个舆情里面肯定非常重要的一方面就是谣言,包括谣言的产生、后面怎么去辟谣,当时是怎么检测到谣言,怎么去做反谣言机制的?

黄萱菁:谣言其实是我们实验室的一个研究方向,谣言检测。我同事魏忠钰他手上带了一个小组来做谣言。从自然语言处理的角度来说,其实谣言的分析,海外我们叫misinformation虚假信息,其实是一个研究内容,国外其实已经有了很多现成的人工标注好的数据,它有很多新闻,然后还有一些假新闻,通过这样的数据可以去训练一个分类去判断这个新闻是不是谣言。

我们当时有了新冠肺炎疫情之后,我们同样面临要建一个数据库的问题,因为我们要用人工智能算法,一定要有训练数据,当时我们找了两方面的数据,一方面就是(微博数据),因为微博上也经常有谣言出现,有辟谣,对吧?然后我们可以用微博自己的这些谣言数据来做训练数据集,然后我们还可以去找公开的、和疫情无关的一些谣言数据,这些数据也可以对我们有用。

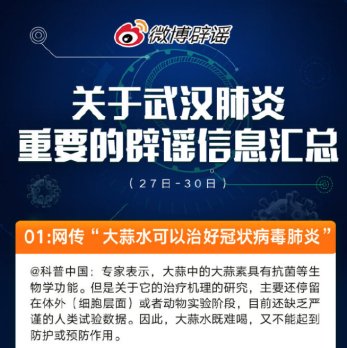

比如有些谣言是跟预防、治疗有关的。像双黄炎口服液能不能治疗新冠,比如什么业主投票,不让医务人员进小区,等等,所以建了这样一个数据集。我们还找了一些公开的一些数据集来做谣言的分析,譬如丁香辟谣,微博辟谣,我们就建立了一个谣言的这样的一个(数据)库。

文章插图

2020年1月辟谣信息汇总 图源:@微博辟谣

然后我们就研究算法,从算法角度来说的话,辟谣实际上也就是一个分类问题,跟我们其他的比如像情感分类、主题分类也没有太大的区别,我们主要是要人去标上一批谣言,然后中间去自动地用神经网络去提特征,这个是传统的思路来做。后来我们还继续做了一些理论研究,我们发了一些谣言检测的文章。这一块的思路是这样:假设新浪微博上,一个新的事情出来了,就有谣言,我不仅可以从内容去分析,还可以从你后续发展(去分析),比如我们说可以“让子弹飞一会儿”,因为谣言出来之后下面有很多评论,可能会有一些人附和他,会有一些人质疑他,而且随着时间的迁移,质疑会越来越多,所以我们可以根据这个信息瀑布流去分析。

我们可以通过用户的跟进的反馈,还有像随着时间的迁移,后续的变化趋势,去预测谣言,做的还可以,我们去年发了COLING的文章,就是用信息流做谣言监测——用这种消息的交互,然后对它进行建模,然后去做谣言检测。

推荐阅读

- 中关村|焦点访谈丨“双减”一学期,效果如何

- 中关村|焦点访谈丨“双减”一学期 效果如何

- 时间|焦点访谈丨“双减”一学期 效果如何

- 中关村|焦点访谈:“双减”一学期 效果如何

- 时间|焦点访谈:“双减”一学期 效果如何

- 阅读理解|期末考试阅读题太难,学生喊话作家求“标准答案”,折射了啥?

- 排球|焦点访谈:体教融合 新思路新探索

- 青少年|焦点访谈:体教融合 新思路新探索

- 微博|学生喊话期末阅读题太难,著名作家回应

- 教师|双减之后,高三普通班复习课太难上,教师:过度关注成绩,很肤浅