访谈|#NLP太难了# 未来媒体访谈对话黄萱菁教授|“NLP+媒体”:科技向善,做有挑战的事( 九 )

(自动文摘技术)其实不能算是成熟,因为目前很多时候都是定制化的,数据是在工业界里面,不是在我们学术界手里的,我们做的更多的是技术,具体的话要应用到上具体任务上,很多时候是我会跟我们已经毕业的同学在聊,他们就会在各个公司里做各种各样有趣的用自然语言处理去赋能的这样一些事情。

未来媒体访谈:还有一个比较常见的问题就是针对新闻文本的纠错,平台上有很多“标题党”这种文不对题的文章,我们第一遍是机器预警,把这个文章检测出来,后面人工进行复核,这一类的纠错问题怎么去提升机器检测它的准确性呢?

黄萱菁:纠错是这样,还是一个匹配问题。比如说,一方面通过匹配你文章和你的题目,我可以去独立的去计算标题和内容的表征,然后看看他们相似程度,这是一个思路,可能比较传统。另外的话,我还可以不看新闻,我直接去对你的标题做价值判断,看你这个标题跟我们人类知识,比如维基百科这样一个现成的、已经建立好的知识之间一致性程度怎么样,如果发现我现有的知识根本不能推导出来你那个命题的话,要么就是你这个命题蕴含着很多的新颖性,要么就是个伪命题。

未来媒体访谈:其实跟谣言的溯源是不是同一个思路?

黄萱菁:

其实对我们自然语言处理来说,我可以面临各种各样的场景,很多技术都是类似的,实际上自然语言处理重要技术,比如首先内容的提取,刚才说为什么喜欢做自然语言处理技术,我从文章到句子到词,然后词之间,词性是什么,然后句子的结构,给词给句子给文章做一个embedding嵌入。这块工作做完之后就可以为下游的很多任务提升性能,那么不管是谣言的检测,还是“标题党”的检测,都可以取得不错的结果。

“我们总归是要说科技向善,要关注它的社会效益,怎么样为全人类的福祉而服务。”

未来媒体访谈:咱们最后一个话题就是回到伦理反思,大家最近比较熟悉的一个问题,就是关于语言表示的性别偏见的问题,尤其可能像新闻或者是其他正式文本训练出来的词项量仍然会带有一些性别上的偏向,可能更多的是职业上会有一些不对等的性别偏向,这个问题有多严重?

黄萱菁:这问题还真的是蛮严重的一个问题,现在假设一个场景,比如一个新出炉的程序员要去求职,然后他的名字比如可能是个很女性化的一个名字,然后另外又来了一个程序员,名字可能是很男性化的,那么现在因为经有很多求职的自动匹配,是根据你个人的信息跟你去算职位的匹配程度的,然后很可能你如果去算出来这个职位的程序员这个职位可能是一个偏男性化的,那么你就会女性就可能匹配度就会降低。这个是很常见的一个问题。

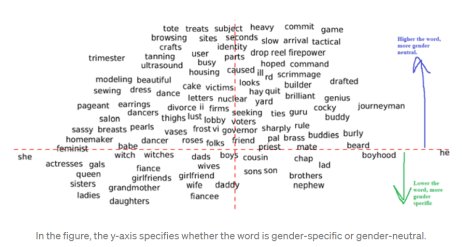

文章插图

性别相关和性别无关的词语,图源:towardsdatascience

主要是因为我们现在学这种词向量,我们都是基于数据驱动的方法,网络世界都是真实社会的反映,不能说是因为学到的词向量有性别偏见,而是因为人类社会带有性别偏见,所以当我们用新闻和现有的百科去训练出来之后,词向量就带偏了。但是我们技术方面需要做一点引领性的技术,你不能永远是跟在大众的后头亦步亦趋、接受现实,我们可以做一点引导性的工作。

比如有一些工作我可以对那个词向量做一个修改,比如把词向量中跟性别无关的成分去掉,什么叫跟性别无关?比如说“爷爷”“奶奶”自然而然带有性别,这样的话就应该保留它,但是有一些比如像“舞蹈演员”、“程序员”、“幼儿园保育员”、“医生”这些职业词汇,不应该带有性别偏见,所以有研究人员说我们可以采用一些词向量加减法,比如“医生”,我给它减掉不应加进去的时候男性的成分,然后生成一个中立的词向量。

推荐阅读

- 中关村|焦点访谈丨“双减”一学期,效果如何

- 中关村|焦点访谈丨“双减”一学期 效果如何

- 时间|焦点访谈丨“双减”一学期 效果如何

- 中关村|焦点访谈:“双减”一学期 效果如何

- 时间|焦点访谈:“双减”一学期 效果如何

- 阅读理解|期末考试阅读题太难,学生喊话作家求“标准答案”,折射了啥?

- 排球|焦点访谈:体教融合 新思路新探索

- 青少年|焦点访谈:体教融合 新思路新探索

- 微博|学生喊话期末阅读题太难,著名作家回应

- 教师|双减之后,高三普通班复习课太难上,教师:过度关注成绩,很肤浅